Serbestlik içsel bir mülk insan beynindeki sinaptik bağlantıların. Gelişim sırasında, tüm sinapsların yarısından fazlası ince taneli ve yapılandırılmamış bir şekilde budanır. Bu budama süreci, beynin dikkate değer olduğu temel faktörlerden biridir enerji verimliliği.

Bundan esinlenerek, seyrek sinir ağları kavramı 1990'ların başlarında önerildi. Teoride, SPARSITY enerji verimliliğini artırabilir. İki büyüklük sırası. O zamandan beri AI'da sıkıştırma ve verimliliği modellemek için ana akım yaklaşımlardan biri haline geldi.

Ama onlarca yıl sonra, Teorik vaadini hala tam olarak fark etmedik. Neden? Bunun ana nedeni, seyrek sinir ağları ve mevcut donanım arasındaki uyumsuzlukta yatmaktadır. Jenga oyununu bir benzetme olarak kullanırsak: beyin, çok fazla boşluklu bir yapı gibi – doğal olarak seyrektir, AI donanımımız sıkı bir şekilde istiflenmiş bir kule gibi doğal olarak yoğundur. Bu nedenle, seyrekliği yoğun donanıma eşlemek kaçınılmaz olarak hantal bir süreci içerir: Donanıma hangi parçaların hesaplanması gerektiğini ve hangilerinin atlanabileceğini söylüyor.

Gizli maliyet: endeksleme

Bazı teknik detaylar ekleyelim. Önemli ağırlıkların nerede olduğu donanımı anlatma sürecine indeksleme. Seyrek sinir ağlarında, ağırlıkların% 90'ından fazlası genellikle budanabilir. Ancak kalan ağırlıklar düzensiz, yapılandırılmamış desenlerde dağıtıldığından, bunlara erişmek tekrarlanan bellek okumaları ve yazma gerektirir. Bu endeksleme işlemi, sistemin enerji ve gecikme bütçesinin çoğunu tüketir.

Yoğun ağlar çağında, von Neumann darboğazından bahsettik – bellek ve hesaplama ayrılması. Şimdi, seyrek dönemde, Dizinleme yeni darboğaz haline geldi.

Mevcut ana akım endüstriyel yaklaşım yerleşim yapılandırılmış ve/veya kaba taneli budama Doğrudan GPU'lara destek. Bazı desen kısıtlamaları ile, seyrek matrisler yoğun olanlara geri sıkıştırılabilir ve verimli bir şekilde işlenebilir. Ancak bu doğruluk pahasına geliyor. Esasen endeksleme yükünü azaltmak için bazı model hassasiyetinden ödün veriyor.

Bu bizi dediğimiz şeye götürür taneciklik ikilemi:

- Kaba taneli, yapılandırılmış seyreklik yüksek enerji verimliliği sunar, ancak düşük doğruluk

- İnce taneli, yapılandırılmamış seyreklik yüksek doğruluk ancak düşük verimlilik sunar

Açıkçası, bu biyolojik beyinlerin nasıl çalıştığından çok uzaktır. İhtiyacımız olan şey sadece daha akıllı algoritmalar değil, aynı zamanda temelde yeni donanım.

Biyolojik bir ipucu ve bellek içi seyreklik

Bu çıkmazı kırmak için sinirbilime geri döndük. Beyinde, sinaps yaratma, budama ve yeniden büyümenin dinamik davranışları nöronların kendileri tarafından değil, çevre tarafından yönetilir. astrositler Ve mikroglial hücre.

Bundan esinlenerek, donanımda olduğuna inanıyoruz, Seyirlik bilgileri, ağırlık bilgisi için mümkün olduğunca yakın saklanmalıdırideal olarak aynı bilgi işlem ünitesinde birlikte bulunur ve doğrudan hesaplamaya dahil edilir.

Bu fikre dayanarak, yeni bir donanım mimarisi öneriyoruz: Bellek içi. Seyrek bir sinir ağının eğitim sürecini Hadamard Ürünü Serçilik matrisi ve bir ağırlık matrisi arasında ve her ikisini de aynı üniteye fiziksel olarak entegre edin. Donanımımız, HF0.5ZR0.5O2, CMOS uyumlu bir ferroelektrik malzeme ve mos₂, temelli ferroelektrik transistörler kullanılarak oluşturulmuştur. iki boyutlu bir yarı iletken. Her bilgi işlem ünitesi iki ferroelektrik transistör içerir:

- Bir analog Ferroelektrik Transistör saklamak için ağırlık değer

- Bir dijital kodlamak için ferroelektrik transistör kıtlıkyani bu ağırlık budanmış olup olmadığı

Silikon işlemleri olan 2D malzemelerin arka uç uyumluluğu sayesinde bu tasarım destekler Monolitik 3D entegrasyon olgun CMOS devreleri ile. Bu, gelişmiş ambalajın ara bağlantı yoğunluk sınırlamalarının üstesinden gelir ve bellek içi bilgi işlem mimarilerinde enerji verimliliğini daha da artırır.

Tabii ki, okuyucuların malzeme detayları hakkında endişelenmelerine gerek yok – sadece bunu unutmayın Bu gibi ortaya çıkan cihazlar, hem veri hem de adresler üzerinde ince taneli kontrole benzeri görülmemiş bir erişim sağlar alt seviyede. Buradaki kilit nokta, SPARSITY'nin programlanmasıdır. peşinharici indeksleme ihtiyacının ortadan kaldırılması. Bu mimariyi temelde farklı kılan şey budur.

Hücreden diziye: VAU

Ancak tek bir üniteden bir diziye ölçeklendiğimizde yeni bir zorluk ortaya çıkar. Bir dizide, bazı sinaptik birimler korunur ve diğerleri budanır. Yine de istiyoruz Kesin yerleri veya büyüklükleri bilmeden ağı eğitin bu tutulan ağırlıkların.

Kulağa imkansız mı? Öyle değil. Aslında, bu tam olarak temel talep seyrek donanım. Dizi düzeyinde pozisyonları bilmemiz gerekiyorsa, hücrenin dizinsiz doğasını gerçekten kullanmıyoruz.

Bir metafor kullanalım.

Birkaç odanın yanıyor olduğu bir apartman hayal edin. Yangınlar yoğunluğa göre değişir ve itfaiyecilerimiz sınırlıdır. Tüm alevleri olabildiğince hızlı ve verimli bir şekilde nasıl söndürüyoruz?

AI eğitiminde, yanan odalar Ağırlıklar (W)yangın boyutu Güncelleme Büyüklüğü (ΔW)ve itfaiyeciler enerji ve gecikmeyi temsil eder.

- Bireysel yangınları ortaya koymak için her pencereye bir itfaiyeci gönderebiliriz – hassas ama son derece yavaş.

- Ya da bir itfaiye aracı getirebilir ve tüm sıralara su püskürtebiliriz – çok daha hızlı, ancak birçok odanın suya ihtiyacı yoktur (ve ıslak komşularınızdan şikayetler alacaksınız).

AI terimleriyle, bu arasındaki değiş tokuş hücre-hücre güncellemeleri (doğru ama yavaş) ve Vektörel güncellemeler (hızlı ama yanlış).

Yaklaşımımız? Öncelikle sakinlerin etkilenmemiş odalarda izin verdik Pencerelerini kapat (yerel programlama). Sonra alevleri paralel olarak söndürmek için itfaiye aracı kullanıyoruz. Elbette, bu bir yaklaşımdır – her oda yangının ne kadar büyük olduğuna bakılmaksızın aynı su basıncını alır. Ama bunun olduğunu gördük yeterince önemli ölçüde doğruve daha verimli.

Bu yöntemi diyoruz Vektörel yaklaşık güncelleme (VAU).

VAU'nun çekirdeği basit:

- Her ağırlığı ayrı ayrı güncellemek yerine, bir ΔW değeri uygularız satır veya sütun başına.

- Her ağırlık olacak iki kez güncellendi (bir kez satır için, bir kez sütun için)

Bu kaçınılmaz olarak Bir sürü yanlış güncellemeözellikle aynı satırdaki güncellemelerin zıt işaretleri olduğunda. Ama işte akıllı kısım: Seyrek sinir ağlarında, çoğu ağırlık zaten budandı. Bu budama birimleri ile donatılmıştır. seyrek transistörlerhatalı güncellemeleri otomatik olarak maskeler. Bu maskeleme yerel, spontane ve harici kontrol gerektirmez. Böylece deneylerimizde VAU, geleneksel, tam indekslenmiş güncellemelerle karşılaştırılabilir doğruluk elde etti – büyüklük siparişleri daha verimli.

Deneysel demo: çipsiz seyrek eğitim

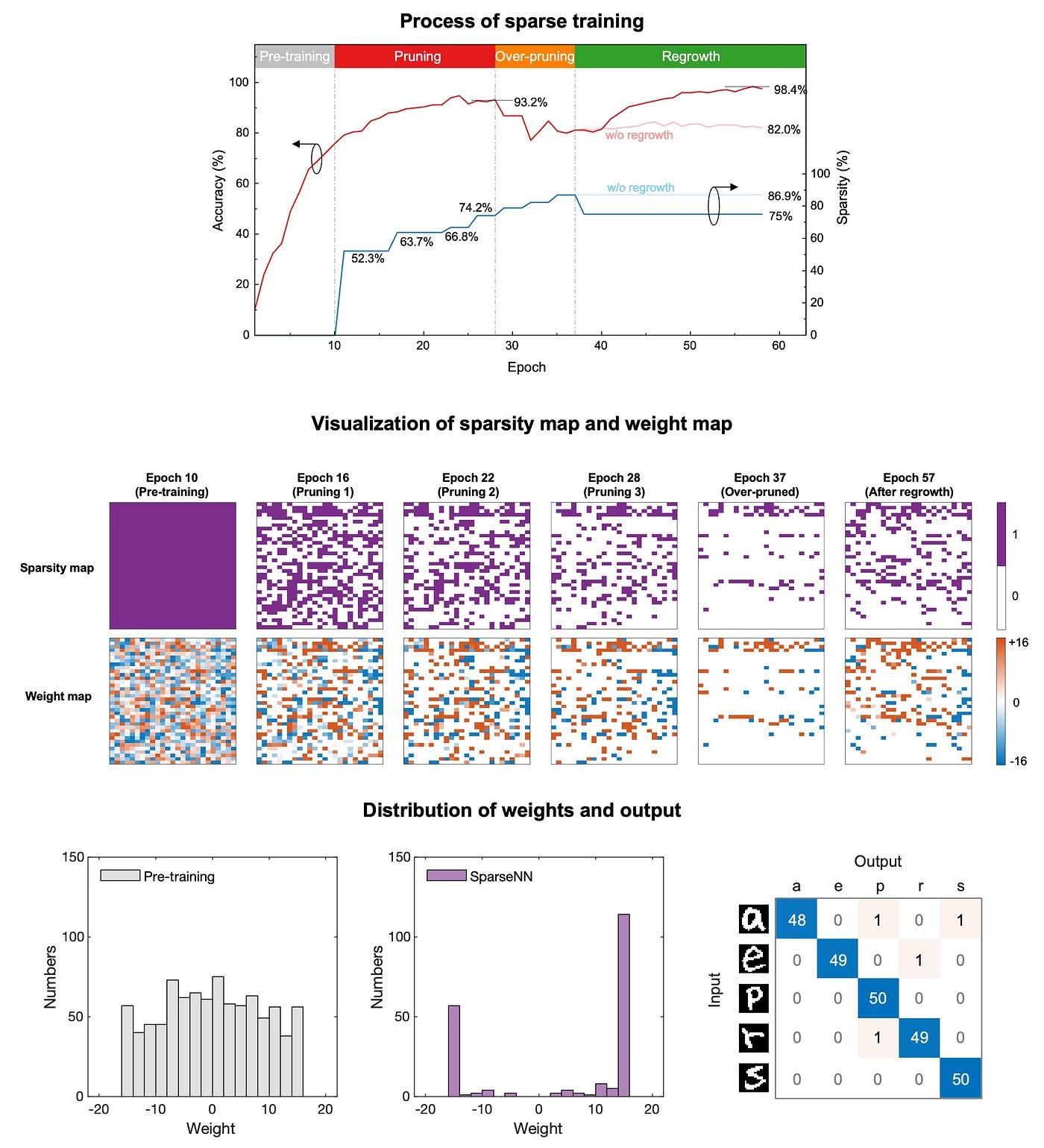

Mimariyi doğrulamak için, yaklaşık 1.000 ağırlık ile mini seyrek bir geleneksel sinir ağı (CNN) tasarladık ve fabrikasyon donanım dizimize eşleştirdik.

Aşağıdakiler dahil olmak üzere birkaç çip içi seyrek eğitim prosedürünü tamamladık.

- Antrenman öncesi

- Budama

- Aşırı yaşama

- Yeniden büyüme

Budama ve yeniden büyüme dönemleri sırasında, hangi ağırlıkların budama veya yeniden büyümeyi bilmek için indeksleme gerekliydi. Ancak diğer tüm seyrek eğitim aşamalarında-ince taneli ve yapılandırılmamış ağırlık dağılımlarına rağmen- İndeksleme tamamen ortadan kaldırıldı.

% 75 Serçilikte donanımımız başardı % 98,4 doğruluk Emnist el yazısı mektup sınıflandırma görevinde.

Ölçeklenebilir mi? Evet!

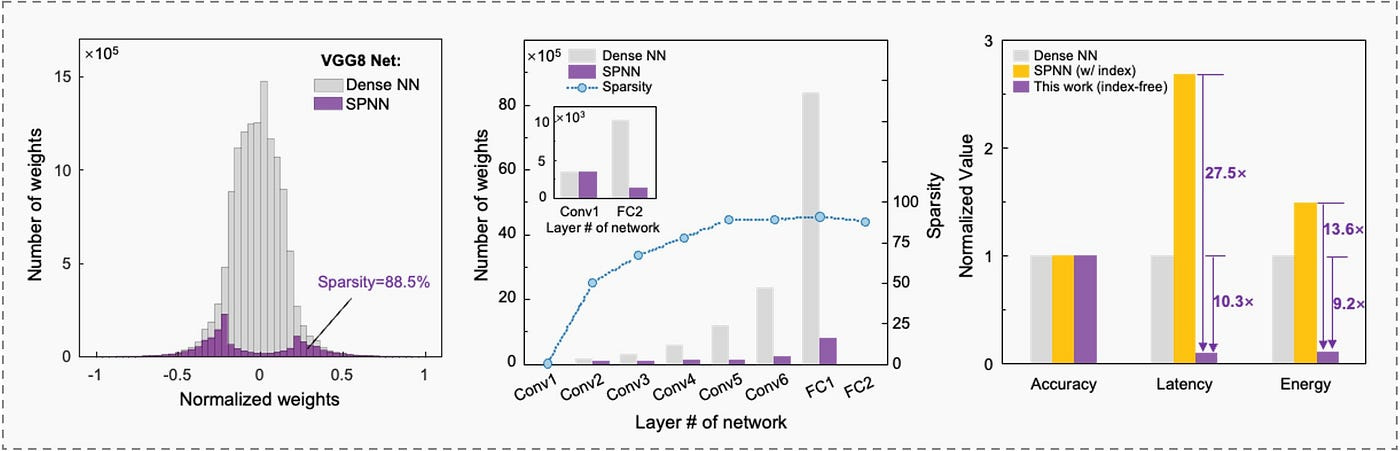

Laboratuvar kısıtlamaları ve ortaya çıkan cihazların olgun olmayan doğası nedeniyle, fabrikasyon dizilerimiz küçüktü ve henüz büyük ölçekli modeller çalıştıramadı. Ölçeklenebilirliği göstermek için klasik VGG-8 CNN'yi üç tür donanımda simüle ettik:

- Yoğun donanım

- Geleneksel seyrek donanım

- Dizin içermeyen seyrek donanımımız

Sonuç: ilk kez, Mimarimiz, enerji ve gecikmede büyüklük sırası iyileştirme sağladıultra ince taneli ve yapılandırılmamış seyreklik altında bile.

Çözüm

İnsan beyninden esinlenerek, ilkini sunuyoruz Konu içi seyrek bilgi işlem mimarisi sinir ağları için. MOS2 ferroelektrik transistörleri üzerine inşa edilen bu tasarım, harici indekslemeyi ortadan kaldırır, doğruluk-verimlilik değişiminin üstesinden gelir ve gerçek zamanlı seyrek eğitimi destekler.

Daha da önemlisi, ortaya çıkan materyallerin ve cihaz düzeyinde yeniliklerin nasıl olabileceğini gösterir Donanım seviyesinde ince taneli programlanabilirliği etkinleştirin -Geleneksel silikon tabanlı teknolojilerin sunamayacağı bir şey.

Bir yanıt yazın